LiDAR-Lösungen für eine sichere und effiziente digitale Welt

Blickfeld LiDAR

Unsere neueste Sensorgeneration: Hochpräzise 3D-LiDAR-Technologie, ergänzt durch intelligente Perzeptionssoftware – für zuverlässige Objekterkennung und Analyse in Echtzeit.

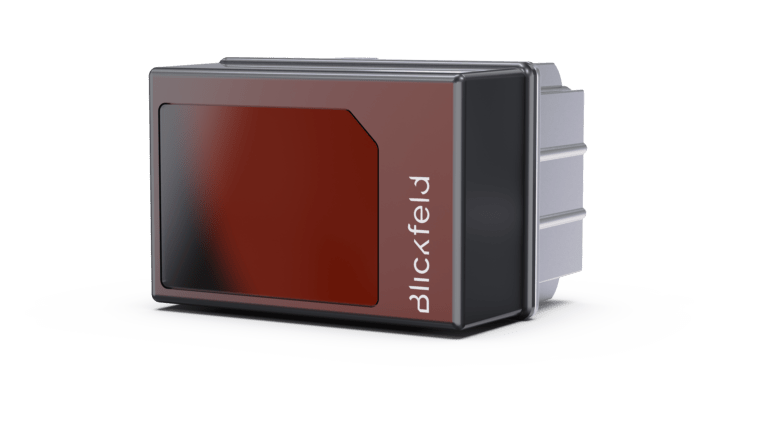

Qb2

3D-LiDAR mit integrierter Datenverarbeitung – geeignet für intelligente Anwendungen wie Personenstromanalysen, Verkehrsüberwachung oder Automatisierung im industriellen Umfeld.

QbBasic

3D-LiDAR-Sensor zur zuverlässigen Erfassung von Punktwolken – konzipiert für OEMs und Systemintegratoren, die eigene Auswertungslogik umsetzen.

QbProtect

3D-LiDAR für Sicherheitsanwen-dungen – erkennt zuverlässig Eindringlinge durch geräteinterne Datenverarbeitung und präzise Erfassung im Außenbereich.

QbVolume

3D-LiDAR zur Volumenmessung – liefert präzise, bedarfsgerechte Daten für effizientes Bestands- und Logistikmanagement.

Referenzen

Blickfeld LiDAR-Lösungen ermöglichen eine Vielzahl an Anwendungen in den verschiedensten Bereichen.

Anwendungsbereiche

News

TAA-Compliance: Qb-Produktportfolio erfüllt internationalen Beschaffungsstandard

Blickfeld setzt weiterhin auf internationale Wettbewerbsfähigkeit: Das gesamte Qb-Produktportfolio – bestehend aus Qb2, QbProtect, QbVolume und QbBasic – ist gemäß den Anforderungen des Trade Agreements

„Selbst das beste Produkt verkauft sich nicht von allein.“

Interview mit Dirk Rathsack – VP Business Development & Sales bei Blickfeld Seit fast einem Jahr verstärkt Dirk Rathsack das Team von Blickfeld als VP

Wie kann die Paket- und Postzustellung in Städten effizienter, flexibler und nachhaltiger gestaltet werden? Diese Frage steht im Mittelpunkt eines zukunftsweisenden Projekts, bei dem ein

Newsletter

Nichts mehr verpassen:

- Updates zu allen Entwicklungen bei Blickfeld

- Spannende Blogposts und Interviews

- Exklusiver Zugang zu Datenblättern, Whitepapern u.v.m.

Mit der Anmeldung zum Newsletter der Blickfeld GmbH erklären Sie sich mit unseren Datenschutzbestimmungen und dem Tracking Ihrer Öffnungsraten einverstanden.