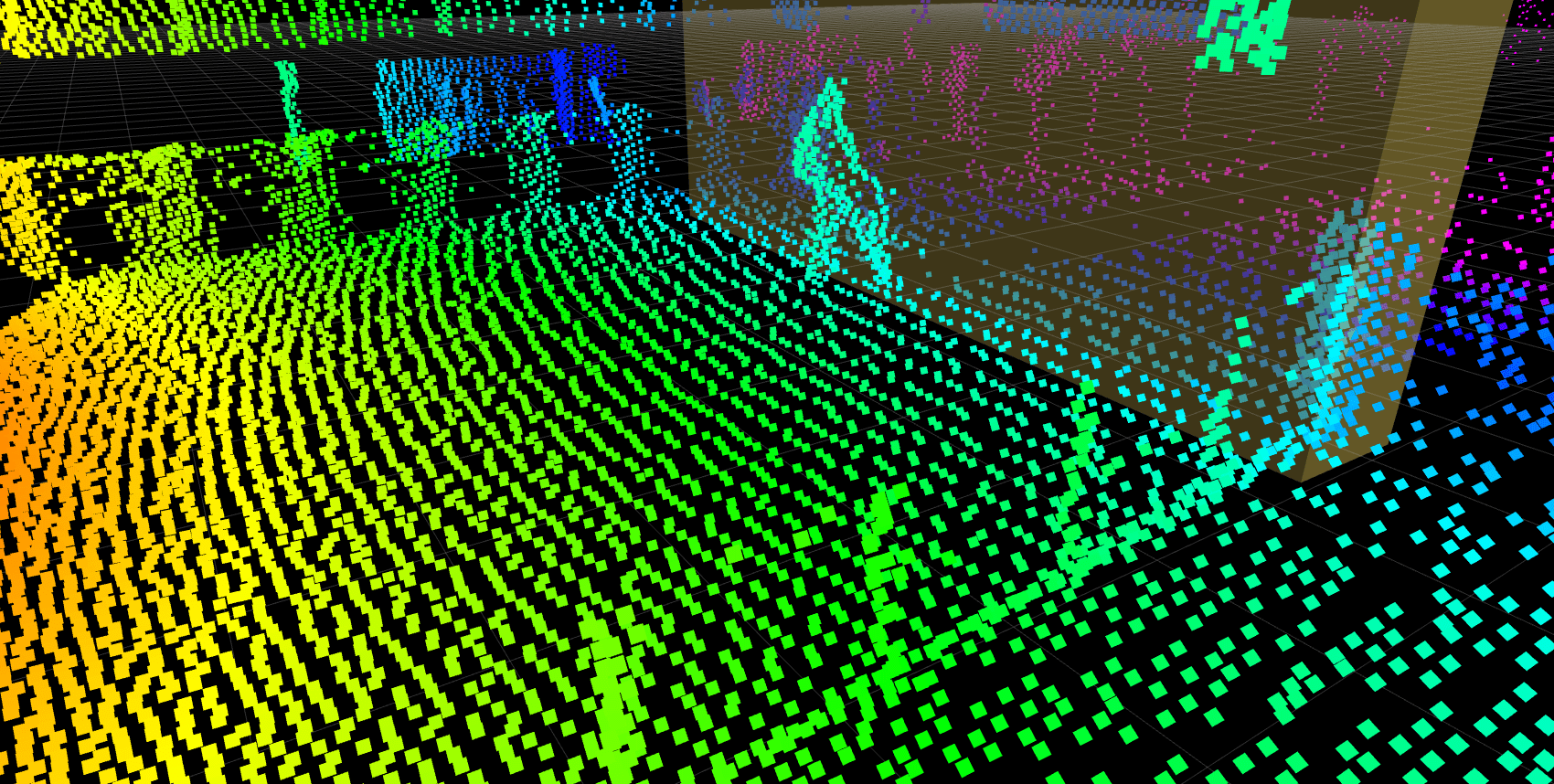

Die Entwicklungen in der LiDAR-Technologie haben eine ganz neue Welt von Anwendungsfällen eröffnet. Die Möglichkeit, anonymisierte Entfernungsinformationen als Punktwolken zentimetergenau zu erfassen, eröffnet in verschiedenen Industrien spannende Perspektiven. Im Normalfall erfassen LiDAR-Sensoren ihre Umgebung und geben die gesamte Szene in Form einer Punktwolke aus, bevor jegliche Datenverarbeitungsschritten folgen. Die unverarbeiteten Punktwolken sind zwar für viele Anwendungen äußerst hilfreich, stellen aber auch eine technologische Herausforderung dar, da sie hohe Ressourcen für die Übertragung, Speicherung und Analyse der großen erzeugten Datenmengen erfordern.

On-Device Vorverarbeitung ermöglicht Bewegungserkennung

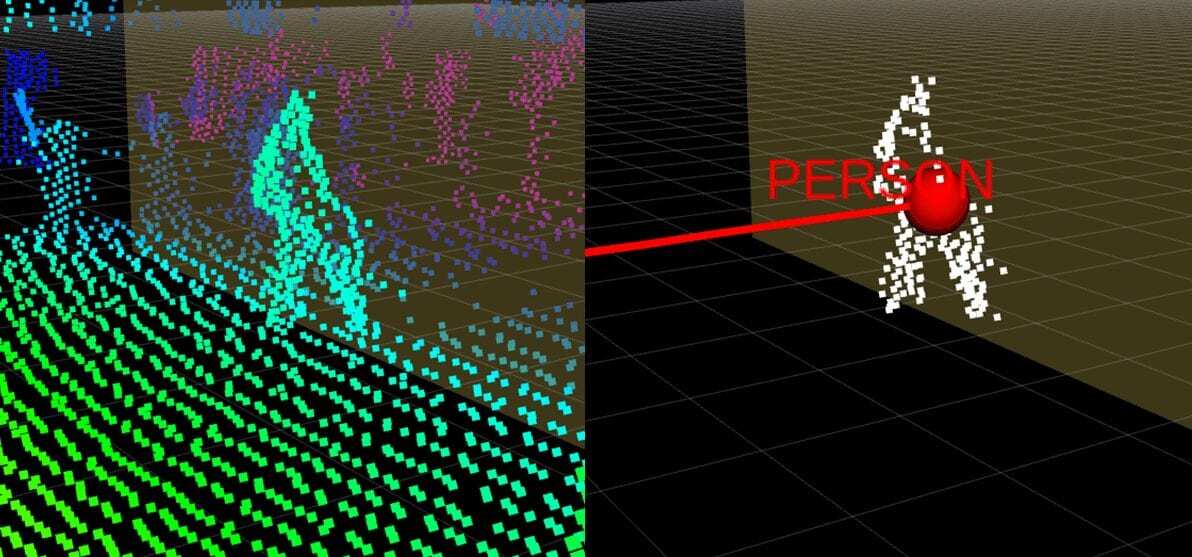

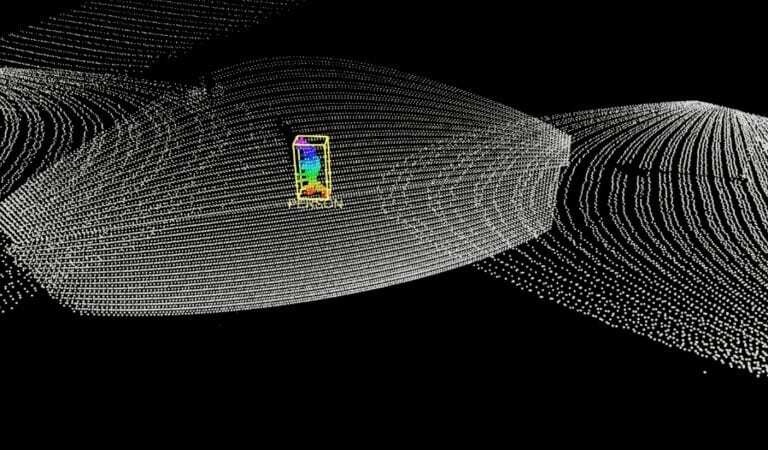

Blickfeld ist dieses Problem mit der Einführung eines Algorithmus angegangen, der direkte Bewegungserkennung auf dem Gerät ermöglicht und dank dieser Vorverarbeitungsfunktionen die Blickfeld Sensoren zu Smart LiDARs macht. Erreicht wird dies, indem der statische Hintergrund bereits auf dem Gerät selbst unter Verwendung des im LiDAR integrierten Hochleistungs-System-on-Chip (SoC) abgezogen wird. Damit ermöglicht die neue Funktion die Extraktion aufschlussreicher Informationen, insbesondere die dynamische Bewegungserkennung, zu einem frühen Zeitpunkt in der Verarbeitungspipeline und erzeugt somit vorverarbeiteter Punktwolkendaten, die für die Analyse und Verarbeitung in den jeweiligen Anwendungen bereitgestellt werden. Obwohl es von der Menge der Aktivität in der Szene abhängt, führt der Algorithmus im Allgemeinen zu einer drastischen Reduzierung der zu übertragenden Datenmenge, insbesondere wenn die Szene überwiegend statisch ist. Wie im Beispiel, müssen >98% weniger Daten übertragen werden, da die Gesamtzahl der Datenpunkte von 8800+ auf nur ~ 163 reduziert wird, was eine lineare Reduzierung des Speichers und der Übertragungszeit zur Folge hat.

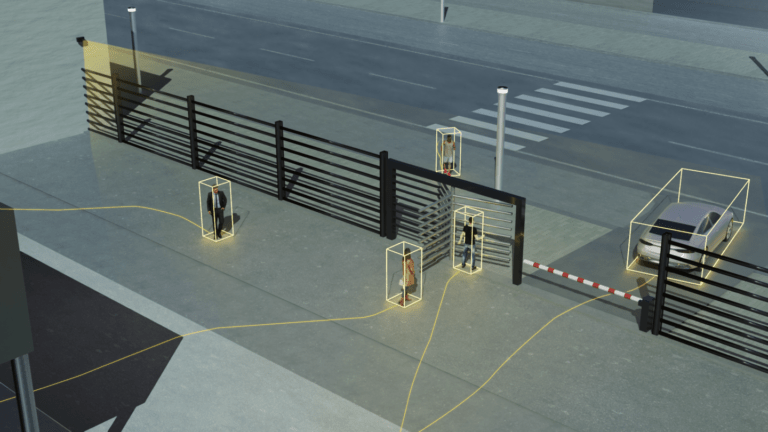

Damit sind LiDAR-Sensoren besser in Anwendungen einsetzbar, die die Erfassung, Verfolgung und Analyse von bewegten Objekten in einer Vielzahl von Umgebungen beinhalten. Zu den Use Cases, die von dieser Funktion immens profitieren, gehören intelligente visuelle Überwachungs- und Trackingsysteme für den Verkehr und auf öffentlichen Plätzen wie Straßen, Bahnhöfen und Flughäfen sowie viele Sicherheitsanwendungen.

So funktioniert die Hintergrundsubtraktion

Der Algorithmus zum Abziehen des Hintergrunds, der die Bewegungserkennung ermöglicht, verwendet eine konfigurierbare Anzahl von Referenzrahmen, um statische Punkte (Hintergrund) in der Szene zu erfassen. Sobald die Referenzframes verarbeitet sind, entfernt er alle statischen Punkte aus der Punktwolke, indem er den erfassten Hintergrund mit dem aktiven Frame vergleicht und die nicht statischen Punkte (Vordergrund) erhält.

Punkte im aktiven Frame, die deutlich vom Hintergrund abweichen, werden als bewegte Objekte erkannt. Diese „Vordergrund“-Punkte werden dann sowohl zur Objektlokalisierung und -tracking als auch zur Bewegungserkennung für verschiedene Anwendungsfälle weiterverarbeitet.

Die Vorverarbeitungsfunktion für die Bewegungserkennung kann für eine Vielzahl von Anwendungen von großem Nutzen sein, z. B. für die folgenden:

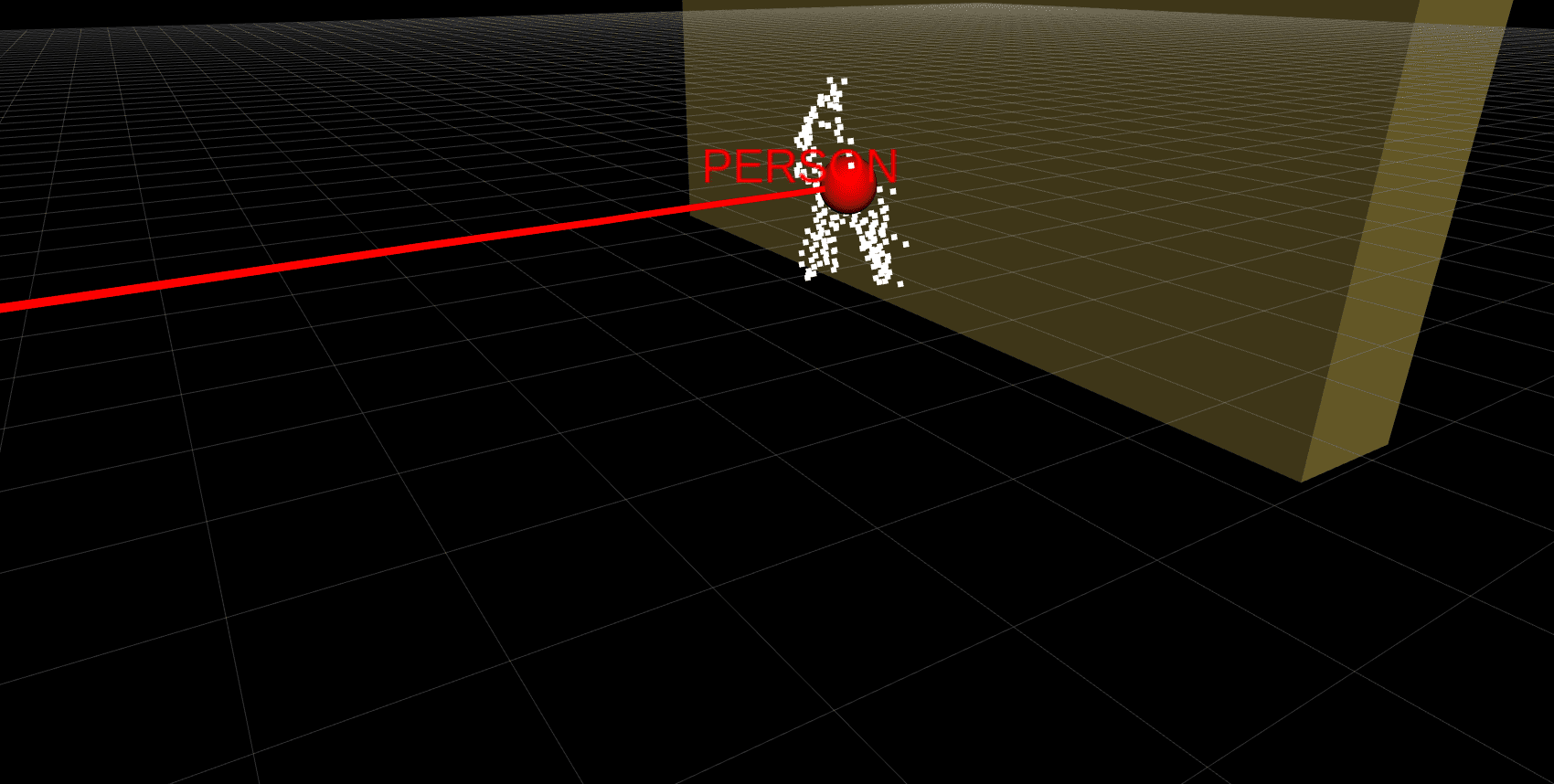

On-Device-Bewegungserkennung für Personenzählung

Personenzählung wird in verschiedenen Umgebungen benötigt, z. B. in Flughäfen, Einzelhandelsgeschäften, Universitäten, Banken oder Freizeiteinrichtungen – im Grunde überall dort, wo Einblicke in die Bewegung von Kunden, Passanten oder Besuchern Mehrwert bringen können.

Die Berechnung der Anzahl von Personen, die eine bestimmte Zone passieren, kann beispielsweise für die Verbesserung von Abläufen und die Optimierung der Ressourcennutzung von Vorteil sein. So können etwa LiDAR-Sensoren am Eingang eines Supermarkts installiert werden, um die Umgebung in 3D zu erfassen.

Indem eine Zone definiert wird, die Personen zählt, die das Geschäft betreten oder verlassen, kann berechnet werden, wie der Personalbedarf während verschiedener Betriebskosten normalerweise aussieht und dieser somit optimiert werden. Dies senkt auf lange Sicht Betriebskosten.

Der erzeugte Datenfeed würde jedoch auch viele statische Objekte wie Türen, Theken, Lebensmittelregale usw. festhalten. Mit dem Algorithmus zur Hintergrundsubtraktion würden nur die sich bewegenden Datenpunkte, also die Personen, über die Verbindung übertragen werden, wodurch die Belastung der Netzwerkressourcen drastisch reduziert wird. Um genau zu sein, betrug in diesem Fall die Gesamtdatenmenge vor der Hintergrundsubtraktion ~3 MB/s pro Sensor, die auf ~0,2Mb/s pro Sensor reduziert wurde.

On-Device-Bewegungserkennung für Verkehrsüberwachung:

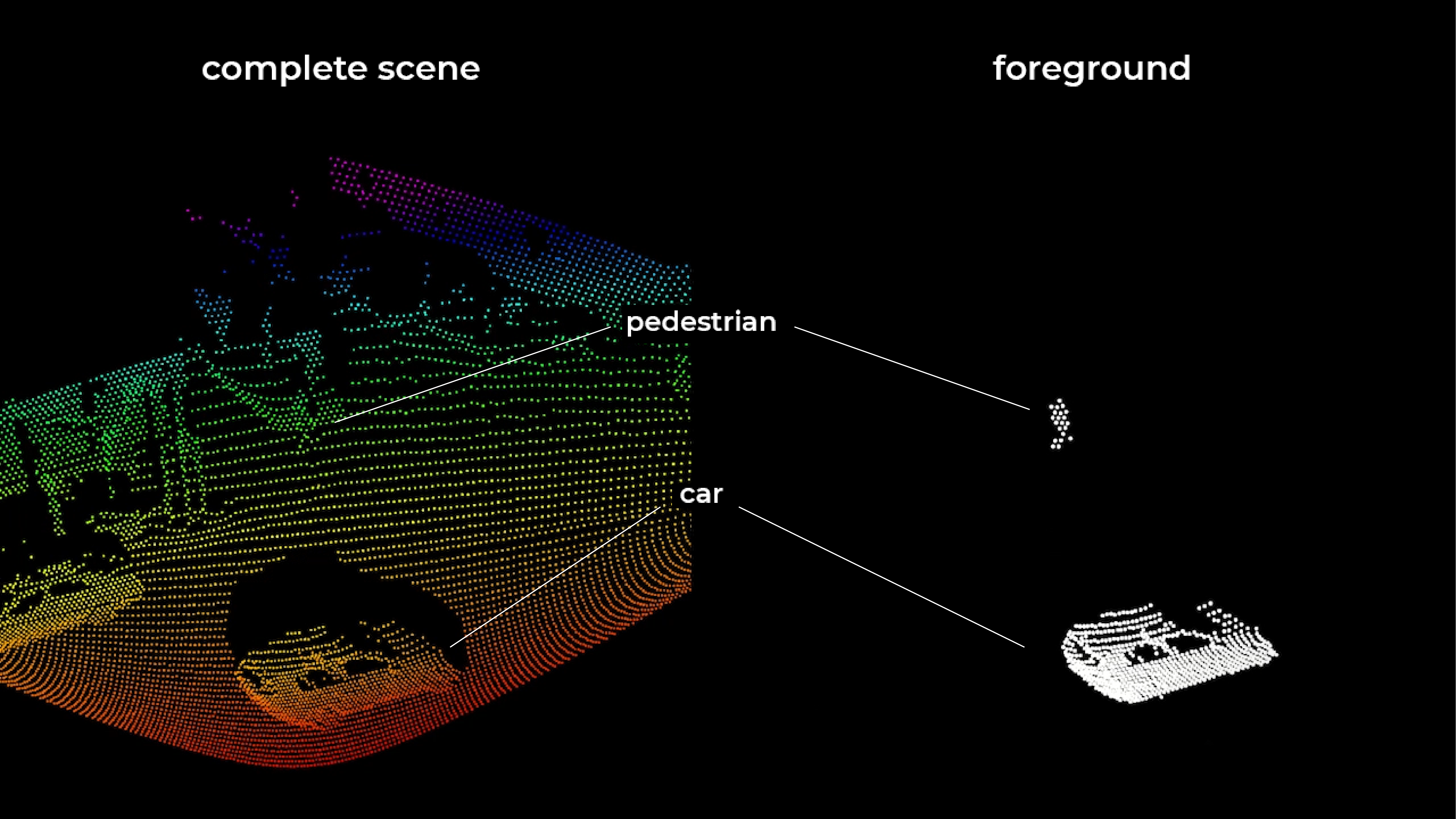

LiDAR-basierte Verkehrsüberwachungssysteme haben großes Potential, da sie 3D-Daten in Echtzeit und anonymisiert liefern. Dies bedeutet, dass das System zwar zwischen einem Fußgänger oder einem Radfahrer in gemischten Verkehrssituationen unterscheiden kann, eine Identifizierung von Einzelpersonen jedoch nicht möglich ist, wodurch die Privatsphäre der Verkehrsteilnehmer geschützt ist. Detailliertere Anwendungen, wie z. B. die Erfassung der Bewegungsdaten verschiedener Verkehrsteilnehmer und anderer Metriken, wie z. B. die Durchschnittsgeschwindigkeit pro Fahrspur, die Anzahl der Fahrzeuge pro Fahrspur, die Verweildauer der Fahrzeuge, die Anzahl der Personen und die Durchschnittsgeschwindigkeit der Fußgänger, können mit LiDAR-Sensoren, die in Verkehrsüberwachungssysteme integriert sind, berechnet werden. Aber auch bei der Verkehrsüberwachung fallen zu jedem Zeitpunkt riesige Datenmengen an, sodass ein dringender Bedarf an intelligenten Lösungen zur Reduzierung des Rechenaufwands besteht.

Analysieren wir beispielsweise eine typische Kreuzung, die mit unseren Smart LiDARs überwacht wird. Eine Punktwolke würde nicht nur aus den Fahrzeugen und Fußgängern bestehen, die sich einer Kreuzung nähern, sondern auch aus statischen Objekten in und um die Szene herum, wie z. B. Bürgersteige, Straßen und Gebäude, wie in der „vollständigen Szene“.

Die On-Device Datenanalysefunktionen des Smart LiDAR würden jedoch die statischen Objekte identifizieren und den Hintergrund entfernen, sodass nur die dynamischen Objekte im Vordergrund wie der Fußgänger und das fahrende Auto übrig bleiben, die als „Vordergrund“ bezeichnet werden.

Dieser Schritt kann die zu verarbeitende Datenmenge deutlich reduzieren und damit die Genauigkeit und Geschwindigkeit der Objekterkennung verbessern und gleichzeitig die Belastung des Netzwerks bei der Übertragung der Daten verringern.

LiDAR-Technologie auf dem Vormarsch

LiDAR entwickelt sich zu einer der vielversprechendsten sensorbasierten Technologien und definiert die Zukunft intelligenter Anwendungen, indem sie räumliche Daten und Insights mit höchster Genauigkeit bieten. Die Smart LiDARs von Blickfeld haben dies auf die nächste Ebene gebracht, indem sie mithilfe der Vorverarbeitungsalgorithmen schnell und einfach verwertbare Erkenntnisse aus Punktwolken extrahieren.

Beginnend mit dem Algorithmus zur dynamischen Bewegungserkennung hat sich die On-Device Hintergrundsubtraktion bereits in vielen Projekten bewährt. Und mit der Erweiterung der Bibliothek an Vorverarbeitungsalgorithmen werden sich viele Möglichkeiten für komplexere Interpretationen der Umgebung und Anwendungsfälle eröffnen, wodurch die Zugänglichkeit und der Nutzen von LiDAR-Sensoren für alle Anwender erhöht wird.